[클라우드 용어집] GPU란 무엇인가?

마케팅커뮤니케이션팀 2024-05-17

지난 4월 9일, 일론 머스크 테슬라 최고경영자(CEO)는 인간보다 더 똑똑한 범용 인공지능(AGI, artificial general intelligence)이 향후 2년 내 탄생할 것을 예고했습니다. 일론 머스크가 설립한 xAI는 이를 위해 챗봇 ‘그록 2.0’을 훈련시키고 있지만 현재 GPU 부족으로 훈련이 더딘 상황이라고 밝혔는데요.

모두가 AI를 이야기하는 것이 마치 골드러시를 방불케 하기도 하는 최근의 AI 열풍을 뒷받침하는 GPU는 무엇일까요? GPU의 등장 배경과 CPU와의 구조적인 차이점, AI 시대에서 GPU의 역할을 아래에서 자세히 알아보겠습니다.

NHN Cloud는 고성능 AI 전용 GPU인 NVIDIA의 H100 장비를 국내에서 최다 보유한 사업자입니다. 각 기업이 AI를 통한 비즈니스 혁신을 완성할 수 있도록 고성능 GPU 자원을 적시에 필요한 만큼 제공합니다. 기업의 AI 여정, NHN Cloud와 함께하면 경쟁력 있는 가격으로 시작할 수 있습니다. 🚀 |

GPU란 무엇인가요?

GPU(그래픽처리장치, graphic processing unit)는 명령어를 순서대로 처리하는 CPU(중앙처리장치, central processing unit)와 달리 병렬 처리에 특화된 그래픽 처리 보조 장치입니다.

1990년대까지만 해도 CPU가 화면 출력까지 담당하였으나 1990년대 중반 시작된 게임 시장의 발전으로 해상도와 색상 수가 증가하면서 화면 출력을 담당하는 독립적인 장치가 필요해졌습니다.

이를 틈타 1999년 엔비디아가 게임 속 3D 이미지 데이터를 효과적으로 처리하는 최초의 GPU인 ‘GeForce(지포스) 256’을 선보였고, 이후 엔비디아를 비롯한 그래픽 카드 회사와 개발자들은 GPU를 그래픽 처리뿐 아니라 범용적인 계산에도 사용할 수 있는 형태로 발전시켜 왔습니다. 이러한 범용 연산 기능을 GPGPU(General-Purpose computing on GPU)라고 부릅니다.

최근 AI 개발을 위한 머신러닝/딥러닝에 GPU를 활용하는 것은 범용 목적으로 GPU를 사용하는 GPGPU라고 볼 수 있습니다. 이처럼 이제 GPU는 비디오 게임 그래픽을 렌더링하는 역할을 넘어 AI 훈련부터 석유 탐사, 자율주행까지 다양한 고성능 컴퓨팅 애플리케이션에 사용되고 있습니다.

CPU와 GPU의 차이는 무엇인가요?

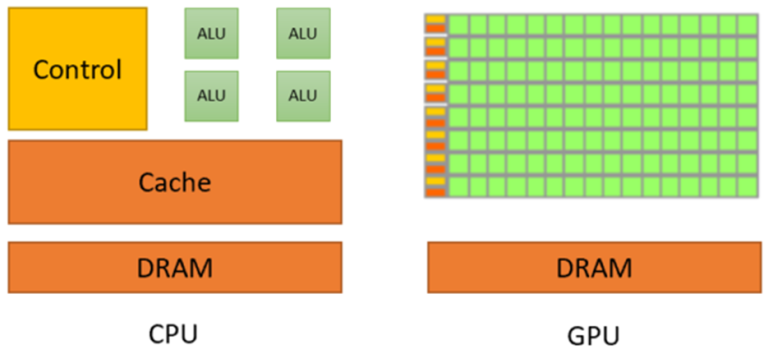

CPU: 커다란 코어(ALU) 4개 vs GPU: 작은 코어(ALU) 수백 개

CPU(중앙 처리 장치)

다양한 환경의 작업을 처리하기 위해 컨트롤 유닛*, 캐시(임시 저장소)*, ALU(산술 논리 연산 장치, Arithmetic Logic Unit)*의 처리 구조가 복잡합니다.

GPU(그래픽 처리 장치)

부동 소수점 연산* 등의 특화된 연산만 처리하기 위해 공통 캐시와 컨트롤 유닛 요소를 공유하는 수많은 ALU로 구성되어 있습니다.

수많은 ALU 가 동일한 명령어로 대량의 데이터를 처리하기 때문에 컨트롤 유닛이 적습니다.

한 번에 하나의 작업을 수행해야 하는 CPU와 달리 GPU는 다중 코어 아키텍처 덕분에 여러 작업을 병렬로 처리할 수 있습니다

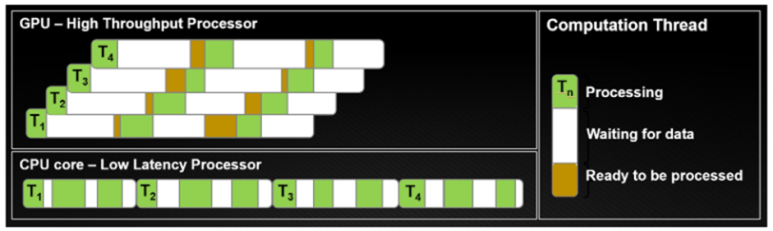

CPU(중앙 처리 장치)

각 스레드가 캐시를 보유하여 데이터 액세스 시간을 최소화(Waiting for data)합니다.

각 스레드 내에서 레이턴시(latency)를 최소화합니다.

싱글 타임 슬라이스(single time slice) 동안 가능한 한 많은 작업(Processing)을 수행합니다.

GPU(그래픽 처리 장치)

동시에 더 많은 스레드를 겹쳐서 메모리 대기 시간을 줄여 대기 시간을 최적화합니다

매 clock cycle 만큼 멈춘 스레드에서 다른 스레드로 전환합니다.

T1 스레드가 데이터 액세스 시간(Waiting for data)을 위해 멈췄을 때 다른 T2가 처리하는 방식으로 T3, T4를 사용합니다. 그동안 T1은 처리할 data를 가져옵니다

CPU

GPU

CPU는 중앙 처리 장치를 의미합니다.

GPU는 그래픽 처리 장치를 나타냅니다 .

CPU는 GPU보다 더 많은 메모리를 소비하거나 필요로 합니다.

CPU보다 적은 메모리를 소비하거나 필요로 합니다.

CPU의 속도는 GPU의 속도보다 느립니다.

GPU는 CPU 속도보다 빠릅니다.

CPU에는 강력한 소수의 코어가 포함되어 있습니다.

더 약한 다수의 코어가 포함되어 있습니다.

CPU는 직렬 명령 처리에 적합합니다.

GPU는 병렬 명령 처리에 적합합니다.

CPU는 낮은 대기 시간을 강조합니다 .

GPU는 높은 처리량을 강조합니다.

📌용어 설명

ALU 산술 논리 장치(Arithmetic and Logical Unit)*

덧셈, 뺄셈 같은 두 숫자의 산술연산과 배타적 논리합, 논리곱, 논리합 같은 논리연산을 계산하는 디지털 회로. CPU의 기본 설계 블록

컨트롤 유닛(Control Unit)*

프로그램의 동작을 어떤 분기로 진행할지 명령어를 해석하고 실행

CPU Control Unit: Branch Predictor, Instruction Cache, Simple Dispatcher 등

GPU Control Unit: INT32, FP32, FP64, Tensor Core 등

캐시(Cache)*

자주 액세스되는 데이터를 담아두는 저장소. 고속 저장 메커니즘 역할을 하여 메모리 대기 시간을 줄이고 전반적인 시스템 성능 향상에 도움

부동 소수점(Floating Point)*

컴퓨터가 데이터를 디지털로 변환하여 저장할 때, 정수/고정소수점/부동소수점 방식 필요

고정 소수점은 10비트를 기준으로 자릿수를 표현해 1024개의 숫자를 표현할 수 있는 반면 부동소수점은 2bit로 자릿수를 표현해 최대 25만 5천 개의 숫자를 표현할 수 있어 정밀한 표현 가능

AI 발전에 왜 GPU가 필요한가요?

현재 AI 개발 분야의 가장 큰 걸림돌은 GPU 품귀 현상입니다. Chat- GPT와 같이 전 세계적으로 성공을 거둔 오픈 AI 조차도 GPU 부족으로 몇 주간 신규 사용자 등록을 중단하는 해프닝이 벌어지기도 했는데요.

인간이 학습하는 방식을 모방하는 머신러닝, 인간 뇌의 특성 중, 뉴런의 연결 구조인 신경망을 모방한 인공 신경망, 인공신경망을 활용해 머신러닝 학습을 수행하는 딥러닝 등 AI 발전을 위해서는 거대한 데이터를 수도 없이 반복 계산해야 하는 고성능 GPU가 필요하기 때문입니다.

이러한 GPU 품귀 현상에 오픈 AI의 샘 알트만은 7조 달러(약 9,000조 원)을 들여서라도 직접 GPU 생산에 도전할 의의가 있음을 밝혔고, 전통적인 CPU 강자 인텔 역시 최근 GPU 생산에 열을 올리고 있습니다.

H100, 신청 즉시 사용하세요

NHN Cloud는 AI 전성시대의 핵심 하드웨어인 엔비디아의 H100 GPU를 국내에서 최다 보유했습니다. 국가 AI 데이터센터 구축과 함께 국산 AI반도체 실증지원 사업을 완수한 유일한 CSP로, 국내 기업이 AI 연구에 집중할 수 있도록 H100을 베어메탈 서버 형식으로 제공합니다.

AI 기업이 선택한

클라우드 서비스 제공사,

NHN Cloud에서는 지금 바로

H100을 경험할 수 있습니다.

![[클라우드 용어집] AX란?(개념, 필요성, 동향, DX와의 차이)](/brand_/storyboard/2025/202510211047061.png)

![[클라우드 용어집] 컨택 센터(Contact Center)란?](/brand_/storyboard/2024/202411221711181.jpg)

![[클라우드 용어집] DaaS/VDI란?(개념, 차이, 장/단점)](/brand_/storyboard/2024/202410161531001.jpg)

![[클라우드 용어집] 금융 클라우드(Financial Cloud)란?](/brand_/storyboard/2024/202409131447131.jpg)